めちゃくちゃ久しぶりにこのブログ書いたw

更新3年ぶりw

> 多様性というゲームは尊厳と自由を勝ち取るゲームなのかもしれないな。

もともとツイッターでツイートした内容なんだけど、ちょっと深ぼる。

-----

自分は男 x 30代x 二児の父 x 経営者 x 都心(共働き世帯が多い)です。

そうなると、どのマジョリティのどのコミュニティにも属しづらくなる。

https://x.com/yunomi_123/status/1864544315701424468

このツイートが自分の中ではとっても好きなので引用

> 生きやすさは「素の自分がどれだけ多数派に近いか」で決まる

生きているコミュニティって、まぁだいたいどのセグメントにいるかによって、マジョリティな行動が決まってくる。

例えば仕事だと

- 経営者 x 30代 -> ほぼ独身、彼女もいるが、遊んでたくてでも結婚するか悩んでいる、みたいな層8割、それ以外にもいるけど年商5000万未満の超零細企業

- 会社員 x 30代 -> 結婚した人がぽつぽつできる、割と男性が周りだと早いが社会動態的には夫婦がピーク

あと、都心でも、

- 港区・江東区・文京区 -> 経営者 + 専業主婦、夫はほぼ子供見てない + 母は教育ママ

- 杉並区、世田谷区 -> もともと東京住み、共働き、初婚年齢男性35歳超え、女子30超え、第一子女子33歳、みたいな感じ(人口動態的に)

みたいな感じで、結構分かれる。

ちゅーことで、素の自分なんてものを出したら、まぁ誰もいないわけで。ライフスタイルも相当多様化しているし、まぁその中でマス層みたいなものがあまり大きくなく、人と違うことについていちいち悩まないといけない現代ってことで、

たとえば、同じ経営者通しでも、仕事と家族の配分とかめっちゃ悩みあるし、自分とかは絶賛子供と仕事のバランスとかでも悩むし、、、、

そんな感じで、生きるレールが生存戦略によってかなり異なるので、こうなんていうんだろう、多様性とか尊重し始めると本当に難しいというかなんというか。

いい年した30代ならわかると思うんだけど、例えば自分が幸せなことを周りに出しづらいような年ってあると思っていて(特に30代女子とかは)、まぁそういうことなんだろうな。

ほんで、多様性尊重なので表出されることなった価値観を受け入れましょう、っていうのもさ、かなり難しいのよね。左脳では理解できても右脳では共感できない。振る舞うしかない。

自分は多様性大事にするタイプだとは思ったけど、シンプルにマイノリティが大好きなだけど、マジョリティをマイノリティが許容するってことって、基本難しいのよね。まあほぼ擬態するって感じになるので。多様性尊重って、実はマイノリティ尊重のように見えるけどね、生きていく上ではマジョリティ尊重なんだよ、っていうのをマイノリティ側は知らないといけないね。大人になるってことは、自分と異なる人を受け入れる、もしくは受け入れると擬態することなので。まぁそれが成熟かっていうと、知らんけどね。生きやすくはなるけど、精神の高次の次元では決してないと思っている派。

ということで、多様性尊重って、結局は尊厳と自由の奪い合いなのかもしれないなって思った。奪うってのがメタ的なコンテクスト読んで振る舞って勝ち取るのかもしれないし、読まずに捻じ曲げるのかもしれないし、わからないけれども。その、なんだろう、マジョリティを受け入れることができるってのが大人なんだろろうね。でも、その中で、「生きてることに遠慮なんてしねえよ」ってのが、きっと尊厳と自由の奪い合いなのかも、、、

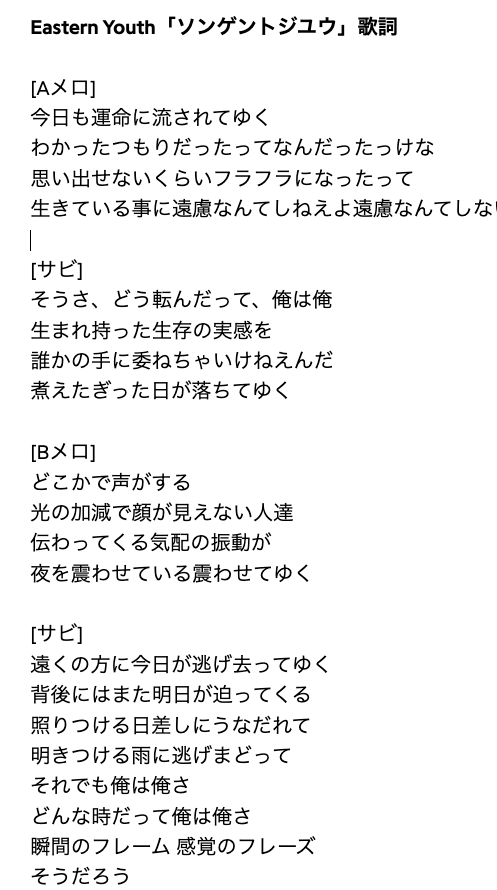

なんてことを、イースタンユースのソンゲントジユウを聞いていて思いました。

本当いい曲なのでおすすめです。